Inteligencia artificial, sesgos actuales… y sesgos futuros » Enrique Dans

Hoy, en mi sección de Radio Nacional, a eso de las 11:30 AM, hablaré de un tema tan interesante como urgente: los sesgos que toda inteligencia artificial arrastra consigo: de dónde vienen, y hacia dónde podrían dirigirse en el futuro.

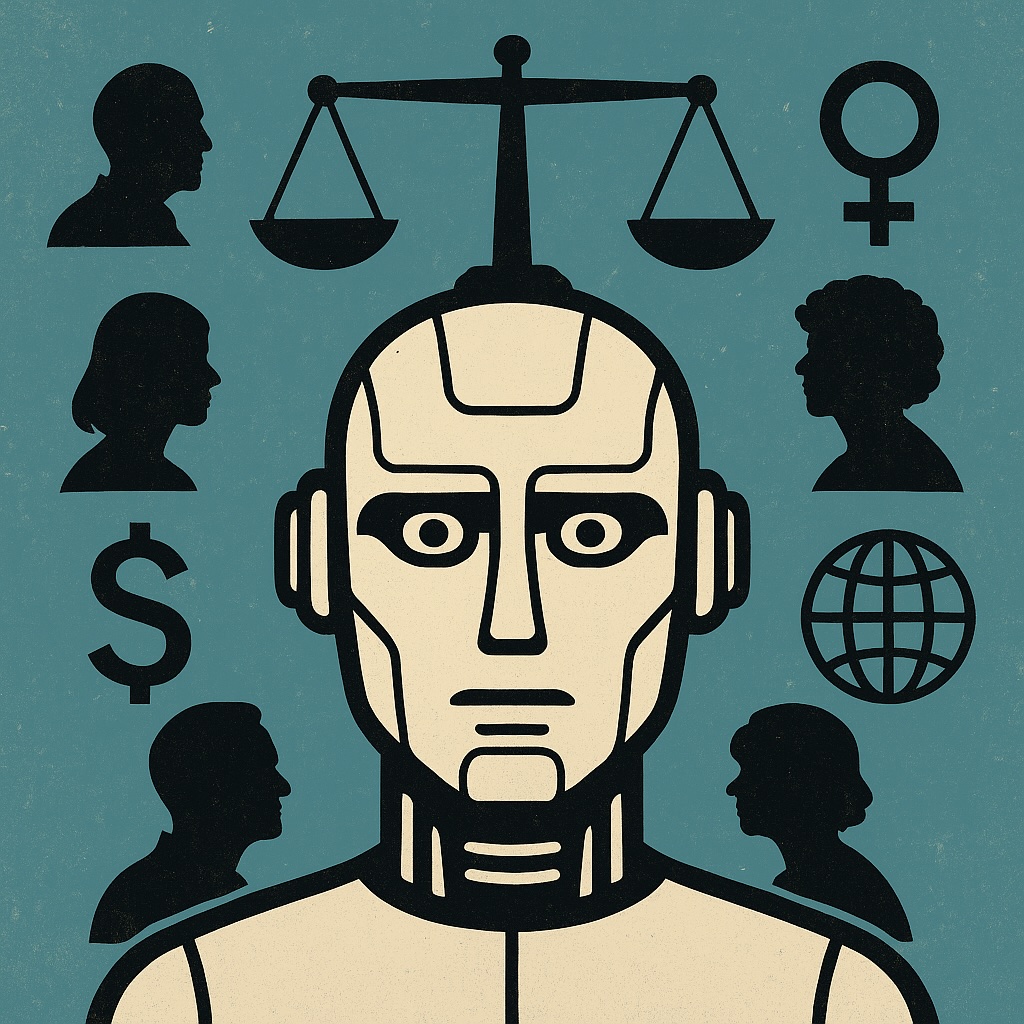

La mayoría de discursos de los profanos sobre inteligencia artificial la elevan a un altar de objetividad: «la máquina no miente», «la inteligencia artificial es imparcial», «si lo dice la inteligencia artificial, es verdad». Pero obviamente, nada más lejos de la realidad. Las inteligencias artificiales no nacen neutrales: su moralidad, sus prejuicios y sus errores los heredan de los datos con los que las entrenamos… y, cada vez más, de los intereses económicos que las impulsan.

Empecemos por lo más «natural», lo más evidente: los sesgos instintivos o nativos que provienen de los datos. Una inteligencia artificial de diagnóstico médico aprende a partir de historiales, imágenes, registros hospitalarios. Si esos datos provienen mayoritariamente de hombres, o de gente de unas edades medias, o de regiones urbanas, la máquina no verá bien lo que haya «fuera de su ámbito de experiencia». Fallará más con mujeres, con personas mayores, con quienes habitan territorios ignorados por el sistema sanitario. Esa no es una decisión consciente de la inteligencia artificial, sino el eco de los sesgos de nuestra sociedad.

Incluso existen sesgos que introducimos nosotros mismos: si pretendemos usar a la inteligencia artificial como psicólogo, una idea completamente absurda pero que parece estar popularizándose, nuestras propias preguntas generan una convergencia en las respuestas que hacen que, salvo en cuestiones muy específicas, tienda a apoyarnos y a darnos siempre la razón. Muy satisfactorio, posiblemente, pero muy poco riguroso, y decididamente, no lo que queremos obtener de un psicólogo. En casos extremos, termina incluso por ayudarnos a escribir nuestra nota de suicidio. Un encanto de psicólogo, la verdad…

Otro claro ejemplo: sistemas de reconocimiento facial que funcionan mejor con personas de piel clara que con personas de piel oscura. O algoritmos de procesamiento de lenguaje que cometen más errores con acentos no estándar o dialectos que no aparecen en sus corpus de entrenamiento. En el ámbito del marketing, los modelos de lenguaje ya ajustan su mensaje según edad, género o nivel educativo, generando slogans distintos para distintos grupos, lo que demuestra que incluso las inteligencias artificiales generadoras de texto discriminan sutilmente.

Pero ese riesgo «natural» ya conocido, aunque no necesariamente por la mayoría de los usuarios, empieza a ser eclipsado por otra fuente de sesgo, más potente y más peligrosa: la publicidad, el patrocinio y el modelo de negocio que subyace en cada plataforma de inteligencia artificial. Por ejemplo, Perplexity anunció que va a insertar anuncios (sponsored follow-up questions o contenido pagado al lado de las respuestas), asegurando que «el contenido de las respuestas no será influido por los anunciantes». Esa promesa, sin embargo, es frágil, porque basta con modificar el peso relativo de determinados temas, priorizar ciertas fuentes o hacer que ciertos anuncios aparezcan primero, para inclinar el resultado. Que una inteligencia artificial de búsqueda titubee entre ofrecer la mejor respuesta y servir al mejor postor es un dilema real.

Mientras tanto, OpenAI ha comenzado a reclutar especialistas en publicidad, personas que vienen de Google o de los sistemas clásicos de monetización, lo que sugiere que la faceta mercantil del negocio de la inteligencia artificial ya está siendo planificada explícitamente. En su más reciente DevDay, los anuncios se centraron menos en la pura potencia de los modelos y más en cómo encajan esos modelos en flujos de trabajo, aplicaciones y ecosistemas donde puede haber incentivos comerciales implícitos.

La confluencia de sesgos nativos y sesgos patrocinados nos lleva a una conclusión incómoda: la inteligencia artificial no es «omnisciente», no es «infalible», y no está por encima de la ética. Cuando decimos «lo dijo la inteligencia artificial», estamos asumiendo que no puede equivocarse. Pero sí puede: omite realidades, silencia voces, privilegia intereses. No hay oráculo: hay modelos estadísticos con prioridades ocultas.

En un estudio reciente titulado «Generative AI search engines as arbiters of public knowledge«, investigadores comprobaron que los modelos de inteligencia artificial muestran sesgos geográficos y comerciales en las fuentes que citan y en el tono con que abordan los temas. Esa «autoridad» artificial puede parecer imparcial, pero muchas veces reproduce los mismos desequilibrios de poder que ya existían.

Entonces, ¿qué hacer? No basta con desplegar más inteligencia artificial; hace falta «inteligencia artificial crítica». Auditorías éticas independientes, transparencia en los criterios de ranking, mitigación de sesgos en los datos, y vigilancia pública sobre cómo se monetizan esos sistemas. Que sepamos no sólo qué dice la inteligencia artificial, sino por qué lo dice.

Que quienes usamos estos sistemas lo presionemos: porque no merece que dejemos decisiones claves relacionadas con todo tipo de ámbitos, desde salud, justicia y crédito hasta reputación y muchas cosas más, en manos de cajas negras sin escrutinio. Hoy hablaré de esto en la radio: que esa voz extra, que suena tan convincente, también merece que cuestionemos su agenda, tanto la «natural», la que refleja nuestros propios sesgos, como la «artificial».

Si me escuchas en RNE sobre los sesgos de la inteligencia artificial (en este enlace a la sexta hora de programa, minuto 27:40), recuerda: no es un problema del futuro, está ocurriendo ya. Y reconocer y entender sus problemas y limitaciones es el primer paso para no caer en ellas.